理化学研究所(理研)生命機能科学研究センター バイオコンピューティング研究チームの張 竣博 研修生(大阪大学大学院 基礎工学研究科 システム創成専攻 博士後期課程1年)、万 偉偉 客員研究員(同准教授)、田中 信行 上級研究員、高橋 恒一 チームリーダー、環境資源科学研究センター 質量分析・顕微鏡解析ユニットの藤田 美紀 上級技師、大阪大学大学院 基礎工学研究科 システム創成専攻の原田 研介 教授らの共同研究グループは、規格化されていない実験環境を認識してロボットアームの動作を自動的に生成し、自律実験を遂行するAIシステムを開発しました。

本研究成果は、人とロボットが一緒に作業する新しい実験室の実現に向けた基盤技術となり、生命科学研究の発展に貢献することが期待されます。

近年、実験科学における人間の手技や処理能力の制約を克服する試みとして、ロボットやAIの活用が進んでいます。しかし、実験室を「ロボットに合わせる」必要があったり、個体ごとに形状が異なる生物試料を正確に認識する技術上の課題があったりするなど、普及に向けて解決すべき点が残されています。

今回共同研究グループは、手先にカメラとピペットを取り付けたロボットアームと、コンピュータ上で再現した実験環境の3次元モデルとを組み合わせることで、適切な実験操作を自律的に生成することができる生成系AI[1]を開発しました。このシステムの活用により、植物の形状を個体ごとに識別し、個別の葉に溶液を添加するなどきめ細やかな実験が自動化できることを実証しました。

本研究は、科学雑誌『IEEE TRANSACTIONS ON AUTOMATION SCIENCE AND ENGINEERING』オンライン版(11月27日付)に掲載されました。

見て考える自動実験ロボットと植物へのきめ細やかな液体添加

背景

現代の生物学研究における基本的な方法論の一つは、検証したい仮説に基づいて、対象となる生命現象を実験室レベルで忠実に再現することです。例えば、特定の遺伝子が生物の表現型を決定しているという仮説に対しては、その遺伝子の働きを制限あるいは増強したときに表現型がどのように変化したかを調べることで検証することが一般的です。かつては、遺伝子のような生体に内在する対象を操作することは非常に困難でしたが、遺伝子改変やゲノム編集に代表される近年のバイオテクノロジーの進展によって今では比較的容易に取り扱うことができるようになりました。

一方、環境の変化や他の生物による刺激など外因性のパラメータを、その影響を受ける生物の特徴に合わせてきめ細やかに設定することは実現できていません。例えば、葉に付着した昆虫は、葉に対して物理的・化学的な刺激を与えることが分かっていますが、実験室レベルで昆虫の付着のような局所的な刺激を再現することは困難です。ヒトが四六時中、実験対象を見ながら手作業で刺激を与え、記録を取り続けるということも想定できますが、認識のばらつきや作業の精度、さらには時間的制約から現実的なアイデアではありません。

生命科学研究における人間の手技や処理能力の制約を克服する試みとして、近年ロボットやAIの活用が進んでおり、植物の栽培と観察の自動化や、iPS細胞を使った再生医療用組織の作製に応用されています注1)。共同研究グループは、外因的な現象の再現についても、ロボットやAIをベースとしたシステムに、さまざまな実験条件に柔軟に対応できる自律性を付与することで、人間が介在しない「自律実験」ができるようになると考えました。

- 注1)2022年6月28日プレスリリース「再生医療用細胞レシピをロボットとAIが自律的に試行錯誤」

研究手法と成果

自律的な実験のためには、実験対象も含めた実験環境を認識し、次にすべき実験動作を考え、実際に実行する機能性が必要です。共同研究グループは自律実験のモデルとして、微量な液体を決められた条件に従ってサンプルに滴下する作業を行うAIシステムの開発に取り組みました。開発にあたっては、人とロボットが同じ場所で一緒に作業することを前提に作られたロボット(協働ロボット)を導入し、実験環境の観察のためのカメラと液体操作のためのマイクロピペット[2]を小型のロボットアームの先端に取り付けました(図1)。この協働ロボットには、人が手取り足取り直接ロボットを動かすことでロボットに動作を教えることができる「ダイレクトティーチング」と呼ばれる機能が備わっています。これにより、使用者がロボットにさせたい動きを教えると、カメラを使って周囲の実験環境を撮影し、画像データからAIを使って実験環境を認識できるようにしました。

図1 カメラとピペットが統合されたロボット先端

カメラで周囲を見ながらロボットがピペット操作を行う。協働ロボットならではのダイレクトティーチング機能とカメラを活用してロボットに"手取り足取り"動作を教えることができる。なお、ロボットアームへのマイクロピペットやカメラの取り付けは、3Dプリンターで作製したパーツの組み合わせで行っており安価に導入可能。

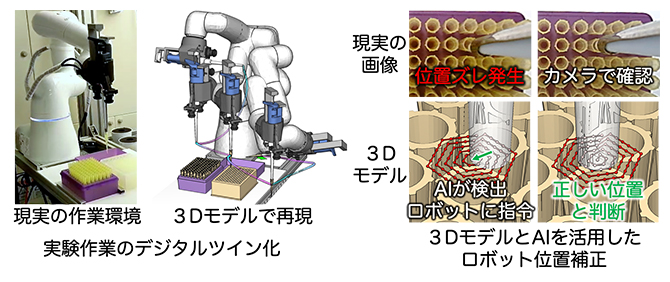

さらにコンピュータ上に、ロボットアームやマイクロピペット、液体容器といった実験環境を3Dモデルで再現するデジタルツイン[3]技術を導入し、実験環境に合わせてロボットアームが周囲の環境と衝突しないなど適切な実験操作を自律的に生成することができる生成系AIを開発しました(図2)。このシステムにより実現したことの一つが、ピペットチップ[2]の取り付け作業の自動化です。生物学研究ではマイクロピペットによる液体操作がよく行われますが、溶液のコンタミネーション(意図しない混合)を防ぐため、通常、使い捨てのピペットチップをピペットに取り付けて使用し、液体操作が終わったらチップを取り外すという作業が行われます。ピペットチップを取り付ける作業は、専門用語でpeg-in-hole作業といわれ、人間は難なくこなせますが、精密な位置合わせや摩擦などを考慮してロボットを制御する必要があることから、一般的な産業用ロボットアームが苦手な作業といわれてきました。今回開発したシステムでは、カメラ画像から市販のピペットチップとロボットに搭載されたピペットとの位置関係をAIが認識することで、ピペットチップが置かれた位置によらず、間違いなく取り付けることができるようになりました。

これにより、実験に使う器具やサンプルの位置を細かく定めなくてもロボットが自律的に認識して動作することが可能となり、またロボットの運動を数値やコマンドで記述することなく、「容器1の溶液をサンプルAに100µL滴下」というような普段の会話のようなわかりやすい実験プロトコル[4]によって複雑な実験条件を指示できるようになりました。

図2 実験のデジタルツイン化

- (左)現実の実験作業環境をコンピュータ上に3Dモデルで再現した。

- (右)使い捨てのピペットチップをマイクロピペットに取り付ける作業の自動化の例。ロボットアームに取り付けられた3Dカメラの画像から、マイクロピペットとチップの位置ずれを検出し、数値化された3DモデルとAIを活用してリアルタイムにロボットの位置を補正する。

次に共同研究グループは、自動化の実証実験として、理研の独自技術である植物自動栽培観察システムRIPPS(RIKEN Integrated Plant Phenotyping System)注2)と、開発した自律実験ロボットを組み合わせました。RIPPSは同時に100個以上の植物サンプルを温度や湿度、光がコントロールされた環境で1カ月以上にわたって自動的に栽培し、成長の様子を観察することができるシステムです。これまでに、乾燥や高温、塩害といった環境ストレスに対する植物の応答を調査するために欠かせないシステムとして力を発揮してきましたが、水やりの量や頻度といった単純な条件を検討するための実験に限られていました。自律実験ロボットとRIPPSを連携させることで、多数の植物サンプルに対して個別に添加する溶液の種類や量、あるいは添加する場所などの実験条件をきめ細やかに定めることができるようになると期待できます。

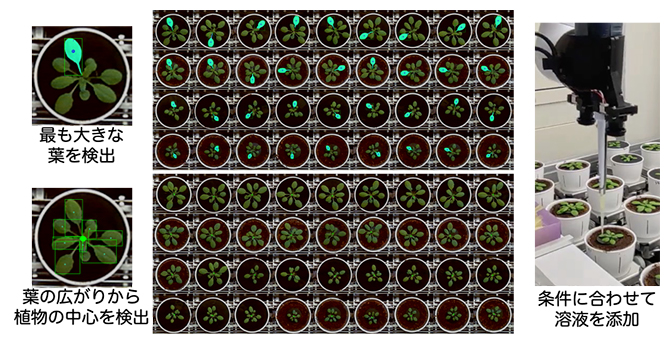

連携にあたって、自律実験ロボットが、ターゲットとなる植物の構造や位置を認識する機能をAIに追加しました。実験器具は工業製品として規格化されていますが、植物はサンプルごとに形状や大きさが異なるばかりか、日ごとさらには朝夕でも時々刻々と変化します。この課題の解決にはデータ駆動型[5]手法を用い、多数の植物画像データを使って教師あり学習[6]を行ったモデルを導入することで、ロボット先端のカメラで撮影された画像から植物の位置や葉の大きさを認識できるようにしました(図3)。これにより、実験室で人が行う実験と同様に、「容器1の溶液をサンプルAの最も大きな葉に20µL滴下」や「容器2の溶液をサンプルBの中心に50µL滴下」と指示するだけで、細かな実験条件を指定することができます。

このシステムを用いて、実際に96個体のシロイヌナズナ[7]を対象に

- ①用意した3種類の薬液のうち1種類を選ぶ

- ②最も大きな葉もしくは植物体の中心に滴下する

という6パターンの比較実験プロトコルの自動化を試みました。その結果、2枚の葉を1枚の葉と誤認識していた3例と、中心位置がややずれて認識されていた1例があったものの、滴下そのものを失敗することはなく、自動化作業は100%の成功率となりました(途中で生育不良を生じた1例を除きます)。

図3 植物サンプルに対する自律実験

- (左)植物の構造や位置を認識する機能を備えたAIシステムの挙動。植物のモデルを組み込むことで、さまざまな植物の形状を個体ごとに認識し、操作対象を自動で検出する。

- (中)多数の植物サンプルに対する検出例。上段は「最も大きな葉」、下段は「植物の中心」を示す。

- (右)検出した対象に合わせて、溶液を添加する様子。

- 注2)2018年7月13日プレスリリース「植物の一挙一動を監視する」

今後の期待

本研究では、「植物」という規格化されていない対象の特徴をサンプルごとに認識して、一定の操作を自動で実行できることを示しました。シロイヌナズナを用いた実証実験からは、このシステムの応用により、作物に付着した病害虫が作物全体に与える影響の調査や、栄養素や化合物の投与が個々の葉に与える影響の「葉の個性」を明らかにする研究などの自動化が可能になると期待できます。

またこのシステムは、単に植物に対して液体を添加するという実験だけでなく、液体操作が主だった作業となる実験の自律化にも貢献できます。例えば、化学合成実験では、複数の液体を混合させることで化学反応が生じ、その結果、反応生成物が得られますが、反応の時間変化や副産物が生じたりするため、反応開始から定期的にサンプルを取り出し、化学反応の品質をチェックすることが一般的です。このような場合に、昼夜問わず定期的にサンプリングすることができ、また色など反応による溶液の変化もカメラで記録でき、基準の色に変化した際に反応を止めるといった、制御された実験が可能になると考えられます。

細胞生物学の実験では、培養細胞に微量の試薬を添加する作業が日常的に行われます。近年、多能性幹細胞[8]から複数種の細胞を分化させ、肝臓や腎臓に近い組織を人為的に作製するミニチュア臓器(オルガノイド)の研究が着目されています。この実験では、本来は発生中の生体内で行われる細胞同士の相互作用による自己組織化をいかに再現するかが課題となっていますが、人間の作業を前提とした実験プロトコルでは、細胞に対して最適な刺激や培養条件が与えられていない可能性があります。自律実験ロボットの応用により、生体内で実際に起きている自然界のプロトコル(nature's protocol)の解明や、より効率の良い実験プロトコルの探索が容易になると考えられます。

今回開発したシステムは、人とロボットが同じ実験器具を用い、同じ場所で一緒に作業することを前提に設計されています。実験自動化のために実験室の大掛かりな改造を必要としないこのシステムは、生命科学研究の加速に貢献すると期待できます。

補足説明

- 1.生成系AI

ユーザが入力した情報を基に、テキストや画像などのデータを新たに生み出す(生成する)機能を持ったAI(人工知能)の総称。自然言語でテキスト入力された質問に対して回答を自動生成するChatGPTなどがある。本研究では、実験操作のためのロボットアームの動きなどを人間がプログラムするのではなく、実験内容を入力すると実験操作に必要な動きを自動生成するAIを開発した。 - 2.マイクロピペット、ピペットチップ

マイクロリットル単位の微量な液体を扱うピペットの本体と、液体を吸排出するための使い捨ての先端部分。ピペットチップは通常、専用の箱に縦に並べられた状態で収納されており、使用する際はマイクロピペット本体の先をピペットチップに突き刺すように押し込んで装着させる。詳細は図1を参照。 - 3.デジタルツイン

現実世界から収集したデータを使い、コンピュータの中に現実世界のコピーを作ること。 - 4.プロトコル

プロトコル(protocol)は儀礼、手順などを意味する英単語で、科学用語では実験の再現に必要な手順やその内容が書かれたものを指す。 - 5.データ駆動型

科学研究のスタイルの一つ。何らかの仮説やモデルを出発点にしてその正しさを実験や観察から得られたデータで検証することで新たな知識を生み出す「モデル駆動」に対し、実験などによって得られたデータを出発点に何らかの法則を見いだし、そこから仮説を生み出すことを「データ駆動」と呼ぶ。 - 6.教師あり学習

入力データとペアとなる正解データを用いて学習し、予測モデルを構築する機械学習の手法の一つ。分類、回帰などが教師あり学習に含まれる。 - 7.シロイヌナズナ

アブラナ科の植物の一つで、「ぺんぺん草」で知られるナズナの近縁種。遺伝子の総量が比較的少なく、発芽から開花し種子が採れるまでの時間が比較的短いことから、被子植物を代表するモデル植物となっている。 - 8.多能性幹細胞

多様な細胞に分化できる分化多能性と、自己複製能を併せ持つ細胞のこと。

研究支援

本研究は、理研エンジニアリング・ネットワーク公募型課題「"Research Gadgets"によるフィジカル・サイバー空間統合」、理研生命機能科学研究センター(BDR)研究自動化プロジェクト、理研-阪大科技ハブ共同研究プログラム「ロボティック育種」、内閣府ムーンショット型農林水産研究開発事業「サイバーフィジカルシステムを利用した作物強靭化による食料リスクゼロの実現(管理法人:生研支援センター)」による支援を受けて行われました。

原論文情報

- Junbo Zhang, Weiwei Wan, Nobuyuki Tanaka, Miki Fujita, Koichi Takahashi, Kensuke Harada, "Integrating a Pipette Into a Robot Manipulator With Uncalibrated Vision and TCP for Liquid Handling", IEEE TRANSACTIONS ON AUTOMATION SCIENCE AND ENGINEERING, 10.1109/TASE.2023.3312657

発表者

理化学研究所

生命機能科学研究センター バイオコンピューティング研究チーム

研修生 張 竣博(チャン・ジュンボ)

(大阪大学大学院 基礎工学研究科 システム創成専攻 博士後期課程1年)

客員研究員 万 偉偉(ワン・ウェイウェイ)

(大阪大学大学院 基礎工学研究科 システム創成専攻 准教授)

上級研究員 田中 信行(タナカ・ノブユキ)

チームリーダー 高橋 恒一(タカハシ・コウイチ)

環境資源科学研究センター 質量分析・顕微鏡解析ユニット

上級技師 藤田 美紀(フジタ・ミキ)

大阪大学大学院 基礎工学研究科 システム創成専攻

教授 原田 研介(ハラダ・ケンスケ)

張 竣博

張 竣博

万 偉偉

万 偉偉

田中 信行

田中 信行

高橋 恒一

高橋 恒一

藤田 美紀

藤田 美紀

原田 研介

原田 研介

報道担当

理化学研究所 広報室 報道担当

お問い合わせフォーム

大阪大学 基礎工学研究科 庶務係

Tel: 06-6850-6131

Email: ki-syomu [at] office.osaka-u.ac.jp

※[at]は@に置き換えてください。