理化学研究所(理研)情報統合本部 ガーディアンロボットプロジェクト(GRP)人間機械協調研究チームの古川 淳一朗 研究員(研究当時)、森本 淳 客員主管研究員の研究チームは、装着者の身体運動情報と一人称視点映像[1]から、装着型運動アシストロボットの制御コマンド(信号)を生成するAI駆動型制御手法を開発しました。

本研究成果は、ロボットを活用した日常動作支援技術として、今後ますます進行する高齢化社会に貢献するものと期待されます。

今回、研究チームは、装着者から計測される身体運動情報と、ウエアラブルカメラの一人称視点映像の情報に基づき、装着者の意図した動作と周囲環境に合わせた適切な制御コマンドを生成するAI駆動型制御手法を開発しました。これは、異なる種類のセンサー情報を効果的に組み合わせる深層学習[2]モデルにより実現しました。この制御手法を、独自に開発を進めている実際の装着型運動アシストロボットに実装し、ヒトの動作負荷を適切に軽減できることが確認されました。

本研究は、科学雑誌『npj Robotics』オンライン版(6月11日付:日本時間6月11日)に掲載されます。

AI駆動型制御による装着型アシストロボット

背景

装着型運動アシストロボットは、高齢化が進む社会において、特にリハビリテーションや介護分野において注目されているロボット技術の一つです。ロボットに求められる動作が定型の運動パターンであったり、特定の施設環境内でのみロボットを運用したりする場合には、事前に決定した動作をロボットに再生させるか、装着者がボタンを操作してロボットを動作させるなどの駆動方法で事足りていました。

しかし、日常生活において装着型運動アシストロボットを使用する場合、求められる動きはさまざまであり、ロボットを使用する環境も刻々と変化するため、装着者の意図を読み取ることで周囲の環境に対応し、より柔軟にさまざまな動作を実行することが求められます。

装着者の動作意図を捉えるために、生体信号情報を用いた意図推定手法が数多く研究されています。生体信号情報として筋電図[3]を用いたアプローチは、精度よく意図を推定できる一方、計測する筋肉の数に合わせたセンサーの取り付けが必要となります。また、センサーの取り付け位置の精度や皮膚との接触状態が計測結果に大きく影響を与えるため、取り付けには高度な専門知識と手技が求められます。そのため、準備から計測に至るまで多くの工程を要し、時間もかかることが課題です。

そこで、研究チームは、取り扱いが難しいセンサーを使用せずに、かつ、装着者の動作意図を推定し、環境に適応可能な駆動を実現する装着型運動アシストロボット技術の開発に挑みました。

研究手法と成果

研究チームは、一人称視点のカメラで装着者の周囲環境を捉えた一人称視点映像を有用な情報源として用いる可能性を検討し、装着型運動アシストロボットが適切に装着者の意図を推定してアシストする制御手法を提案しました。具体的には、一人称視点映像と、装着者の関節角度や角速度、胴体部の回転運動情報で構成される身体運動情報を入力とします。これらの情報に基づき、装着型運動アシストロボットの制御コマンドを出力する、Transformer[4]をベースにした深層学習モデルに基づくアシスト動作生成手法を提案しました。本手法は、装着者の周囲環境と身体運動パターンの相互関係を学習することで、装着者の動作を予測し、適応的なアシスト動作を実現します。一人称視点映像を取り入れ、扱いが難しい生体信号を用いることなくアシストロボットを制御している点が、本研究の独自性となっています。

この手法の検証は2段階の実験で行いました。

- 第1段階のデータ取得実験と提案手法モデルの学習

本研究では、株式会社国際電気通信基礎技術研究所(ATR)と共同で独自開発を進めている装着型運動アシストロボットを使いました。このロボットは、空気圧人工筋アクチュエータをカーボン樹脂でできたフレームに内蔵することで、非常に軽量であり、制御がない状態でも装着者は軽快に動作を行えるのが特徴です。

この装着型運動アシストロボットの装着者に、アシスト動作制御を行わない状態で、「歩行する」、「しゃがんで床にある物体を拾う」、「段差を上る」といった複合動作を、自由な順序で補助なく行ってもらいました。その際の一人称視点映像、関節角度、角速度、胴体部の回転運動などの身体運動情報を計測するとともに、装着者には、動作中に「アシストが必要」または「不要」と感じた区間を、手に持ったボタンを介して自由にラベル付け[5]してもらいました。このようにして得られた、一人称視点映像や装着者の身体運動情報とアシストの要否ラベルが付与されたデータセットを用いて、提案手法モデルの学習を行いました。 - 第2段階のリアルタイム制御によるアシスト実験

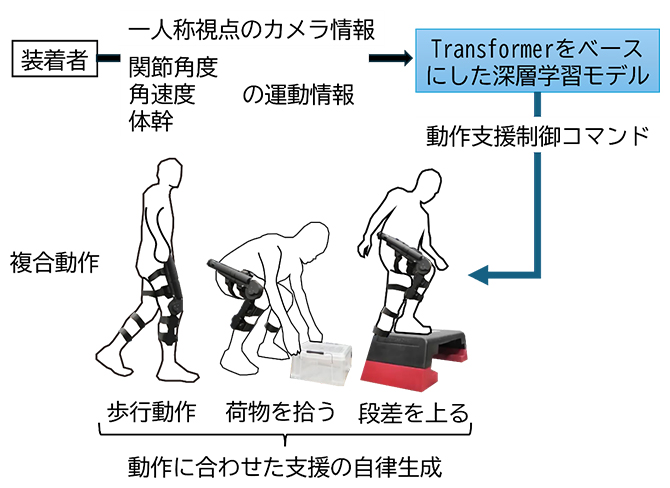

第1段階で学習したモデルによる提案手法を、上述した装着型運動アシストロボットに実装し、ロボットシステムとして構築しました。このロボットシステムを用いたリアルタイム制御による動作支援実験では、運動アシストロボットの装着者は自由な順序で同様の複合動作を行うことで手法の有効性を検証しました(図1)。動作支援の有効性は、実験参加者の筋活動および心拍を計測して評価し、ロボットのアシスト動作生成の精度は、従来手法として筋電図に基づく手法を実装し、比較することで検証しました。

図1 提案手法を用いたロボットシステムによる動作支援

装着者から得られる一人称視点映像と関節角、角速度、胴体部の回転運動情報を入力とし、Transformerをベースにした深層学習モデルから動作や周囲環境に合わせた動作支援制御コマンドが生成される。実験設定では、歩行、荷物を拾う、段差を上る、から構成される複合動作で実施された。

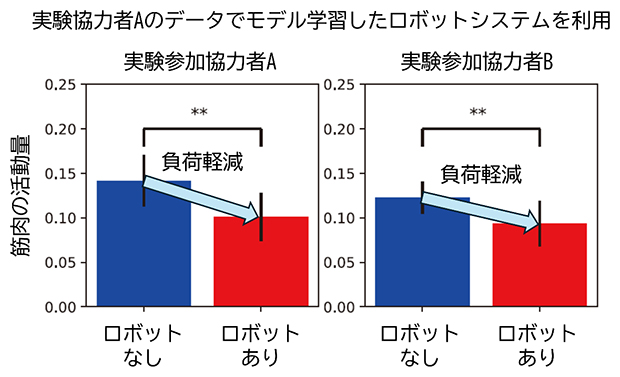

その結果、提案手法を用いた装着型運動アシストロボットによる支援がある場合とロボットを装着していない場合とを比べて、装着者の筋活動量が軽減されることが分かりました。さらに、このロボットシステムを新たな実験参加協力者に適用したところ、同様に筋活動量が軽減されることが確認されました。これにより、制御モデルが他者に対しても高い精度で汎化[6]する可能性が示唆されました(図2)。一方、ロボットのアシスト動作の生成に関しては、筋電図を用いた従来手法と同程度、あるいはそれ以上の精度が達成できることも確認されました。

図2 動作支援による身体への影響

提案手法を用いた装着型運動アシストロボットによる支援がある場合と、ロボットを装着してない場合の筋活動量。ここで用いた制御モデルは実験参加協力者Aのデータを用いて学習されており、実験参加協力者Bのデータは用いられていない。実験参加協力者Bの身体負荷も軽減されていることから、精度よくアシスト制御ができていることが分かる「**」:有意水準1%での有意差あり。

今後の期待

筋電図などの生体信号のセンサーはウエアラブル化が進んでいますが、まだその扱いは高い専門性が必要で容易ではありません。このようなセンサーに頼らずに高い性能を達成することは、システムの実用性を高めるために重要です。本研究では、一人称視点映像と装着者の身体運動情報を効率よく統合することで、適切な動作支援の制御コマンドを生成する、AIを用いた装着型運動アシストロボットの制御手法を提案し、生体信号センサーに頼らずとも、精度の高いアシスト動作制御ができる可能性を見いだしました。これにより、装着型運動アシストロボットの自律的な制御技術の向上に貢献できると期待されます。

また、日常生活において装着型運動アシストロボットが簡易に活用されるための技術として有効だと考えられます。

補足説明

- 1.一人称視点映像

カメラの視点が対象者の視点と一致している映像。対象者とも被写体とも異なる位置にあるカメラからの映像は三人称視点映像となる。 - 2.深層学習

大規模な統計モデルを構築し、データに潜む関係性を学習することで、高度な予測を行う情報技術。 - 3.筋電図

電極(センサー)を用いて、筋肉で発生する微弱な電気的活動を捉えたもの。 - 4.Transformer

時間的に並んだデータの中で、各時点の情報が他のどの時点と強く関係しているかを自動で見つけ出し、その関係性を基に処理を行うAIモデル。2017年にgoogleの研究チームが発表した。[Vaswani, A. et al., Attention is all you need, NeurIPS, 2017]。 - 5.ラベル付け

データに意味のある情報を付加することで、AIなどのモデルのパラメータを学習する際の手本となる。 - 6.汎化

学習した知識やルールを、学習していない新しいデータや状況にも適応できる能力のこと。

研究チーム

理化学研究所 情報統合本部 ガーディアンロボットプロジェクト(GRP)

人間機械協調研究チーム

研究員(研究当時)古川 淳一朗(フルカワ・ジュンイチロウ)

客員主管研究員 森本 淳(モリモト・ジュン)

(株式会社国際電気通信基礎技術研究所(ATR)脳情報研究所 ブレインロボットインタフェース研究室 室長、京都大学 大学院情報学研究科 教授)

研究支援

本研究は、理化学研究所運営交付金(ガーディアンロボットプロジェクト)で実施し、日本学術振興会(JSPS)科学研究費助成事業基盤研究(B)「アシストロボットのための主観視点画像と筋肉動態を融合した学習制御(研究代表者:古川淳一朗)」「作業価値関数の相互獲得を通じた人とロボットの共有学習制御手法の開発(研究代表者:森本淳)」による助成を受けて行われました。

原論文情報

- Jun-ichiro Furukawa, Jun Morimoto, "Transformer-based multitask assist control from first-person view image and user's kinematic information for exoskeleton robots", npj Robotics, 10.1038/s44182-025-00033-4

発表者

理化学研究所

情報統合本部 ガーディアンロボットプロジェクト(GRP) 人間機械協調研究チーム

研究員(研究当時)古川 淳一朗(フルカワ・ジュンイチロウ)

客員主管研究員 森本 淳(モリモト・ジュン)

古川 淳一朗

古川 淳一朗

報道担当

理化学研究所 広報部 報道担当

お問い合わせフォーム